Pregúntale a cualquier persona en la comunidad de inteligencia artificial de código abierto y te dirán que la brecha entre ellos y las grandes empresas privadas es más que solo poder computacional. Ai2 está trabajando para solucionar eso, primero con bases de datos y modelos completamente de código abierto y ahora con un régimen de post-entrenamiento abierto y fácilmente adaptable para convertir los grandes modelos de lenguaje en bruto (LLMs) en modelos utilizables.

A diferencia de lo que muchos piensan, los modelos de lenguaje «fundamentales» no salen del proceso de entrenamiento listos para ser utilizados. El proceso de pre-entrenamiento es necesario, por supuesto, pero está lejos de ser suficiente. Incluso se cree que el pre-entrenamiento pronto podría dejar de ser la parte más importante del todo.

Eso se debe a que cada vez se muestra más que el proceso de post-entrenamiento es donde se puede crear un valor real. Ahí es donde el modelo se moldea desde una red gigante y omnipotente que producirá tan fácilmente puntos de discusión de negación del Holocausto como recetas de galletas. ¡Por lo general, no quieres eso!

Las empresas son muy reservadas sobre sus regímenes de post-entrenamiento porque, si bien cualquiera puede raspar la web y hacer un modelo utilizando métodos de vanguardia, hacer que ese modelo sea útil para, digamos, un terapeuta o un analista de investigación, es un desafío completamente diferente.

Ai2 (anteriormente conocido como el Instituto Allen para la IA) ha hablado sobre la falta de transparencia en proyectos de IA supuestamente «abiertos», como el Llama de Meta. Si bien el modelo es de hecho gratuito para que cualquiera lo use y lo ajuste, las fuentes y el proceso de creación del modelo en bruto y el método de entrenamiento para uso general siguen siendo secretos cuidadosamente guardados. No está mal, pero tampoco es realmente «abierto».

Ai2, por otro lado, se compromete a ser lo más transparente posible, desde exponer su recopilación de datos, curación, limpieza y otras pipelines hasta los métodos exactos de entrenamiento que utilizó para producir LLMs como OLMo.

Pero la verdad simple es que pocos desarrolladores tienen la habilidad para ejecutar sus propios LLMs desde el principio, e incluso menos pueden hacer el post-entrenamiento de la forma en que lo hacen Meta, OpenAI o Anthropic, en parte porque no saben cómo, pero también porque es técnicamente complejo y lleva mucho tiempo.

Afortunadamente, Ai2 también quiere democratizar este aspecto del ecosistema de IA. Ahí es donde entra Tülu 3. Es una gran mejora sobre un proceso de post-entrenamiento anterior y más rudimentario (llamado, has acertado, Tülu 2). En las pruebas de esta organización sin fines de lucro, esto resultó en puntuaciones al nivel de los modelos «abiertos» más avanzados que existen. Se basa en meses de experimentación, lectura e interpretación de lo que los grandes están insinuando, y en muchas carreras de entrenamiento iterativas.

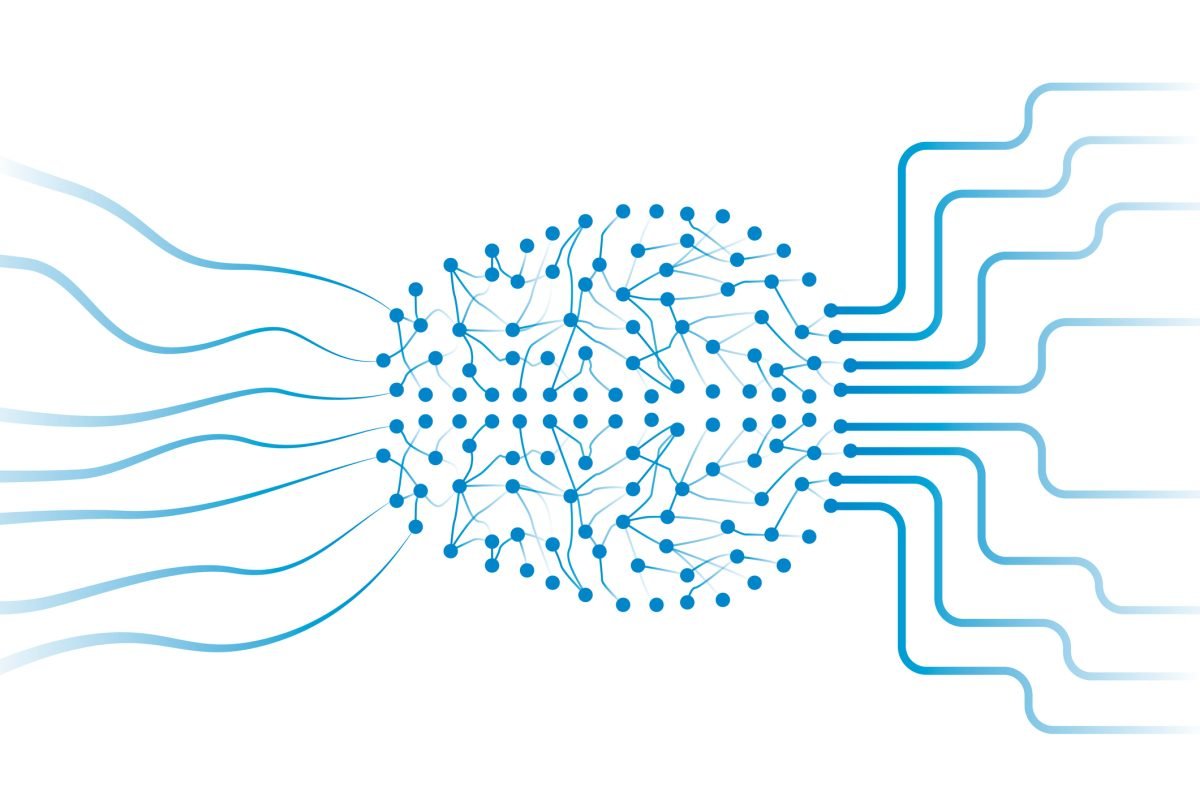

Una diagrama no captura realmente todo, pero se puede ver la forma general.Image Credits: AI2

Básicamente, Tülu 3 cubre todo, desde elegir los temas por los que deseas que tu modelo se preocupe -por ejemplo, disminuir las capacidades multilingües pero aumentar las de matemáticas y codificación- hasta llevarlo a través de un largo régimen de curación de datos, aprendizaje por refuerzo, ajuste fino y ajuste de preferencias, para retocar un montón de otros meta-parámetros y procesos de entrenamiento que no podría describir adecuadamente. El resultado es, con suerte, un modelo mucho más capaz enfocado en las habilidades que necesitas que tenga.

Pero el punto real es quitarle un juguete más a las empresas privadas. Anteriormente, si querías construir un LLM entrenado personalizado, era muy difícil evitar utilizar los recursos de una empresa importante de una forma u otra, o contratar a un intermediario que hiciera el trabajo por ti. Eso no solo es costoso, sino que también introduce riesgos que algunas empresas se resisten a asumir.

Por ejemplo, empresas de investigación médica y de servicios: Claro, podrías usar la API de OpenAI, o hablar con Scale o quien sea para personalizar un modelo interno, pero ambos involucran a empresas externas en datos de usuarios sensibles. Si es inevitable, simplemente tendrás que aceptarlo, pero ¿y si no lo es? ¿Como si, por ejemplo, una organización de investigación publicara un régimen completo de pre- y post-entrenamiento que podrías implementar internamente? Eso bien podría ser una mejor alternativa.

Ai2 lo está utilizando él mismo, lo cual es la mejor recomendación que se puede dar. Aunque los resultados de prueba que están publicando hoy usan a Llama como un modelo fundamental, están planeando lanzar pronto un modelo entrenado de OLMo basado en Tülu 3 que debería ofrecer aún más mejoras sobre el valor base y también ser completamente de código abierto, de cabo a rabo.

Si te interesa cómo se desempeña el modelo actualmente, prueba la demostración en vivo.